Table of Contents

1. Thuật toán Kernel Inducing Points là gì?

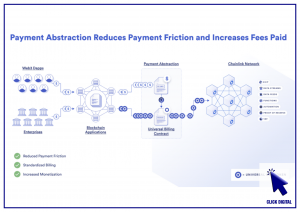

Kernel Inducing Points (KIP) hoạt động bằng cách chọn một tập con nhỏ các điểm dữ liệu từ tập dữ liệu gốc, được gọi là các điểm dữ liệu gây ra. Các điểm dữ liệu gây ra này được sử dụng để xây dựng một mô hình kernel, có thể được sử dụng để suy luận về các điểm dữ liệu còn lại trong tập dữ liệu gốc.

Cụ thể, KIP sử dụng một kernel để tính khoảng cách giữa các điểm dữ liệu trong tập dữ liệu gốc. Các điểm dữ liệu có khoảng cách nhỏ hơn sẽ được coi là các điểm dữ liệu gây ra.

Thuật toán Kernel Inducing Points (KIP) này là một thuật toán học meta được giới thiệu bởi Timothy Nguyen (1 người Việt làm việc tại Google Research). Toán học meta là một lĩnh vực của học máy tập trung vào việc phát triển các phương pháp chung để cải thiện hiệu suất (hay còn gọi là tự học).

2. Dùng để huấn luyện học máy như thế nào?

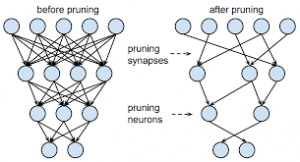

KIP có thể được sử dụng để huấn luyện các mô hình học máy theo nhiều cách khác nhau. Một cách phổ biến là sử dụng KIP để chọn một tập con nhỏ các điểm dữ liệu từ tập dữ liệu gốc. Tập con này sau đó được sử dụng để đào tạo một mô hình học máy.

Một cách khác là sử dụng KIP để xây dựng một mô hình học máy nhỏ hơn, được gọi là mô hình Student (học sinh). Mô hình Student này sau đó được đào tạo trên tập dữ liệu gốc và các điểm dữ liệu gây ra được chọn bởi KIP.

3. KIP được sử dụng cho những tác vụ gì?

KIP có thể được sử dụng cho nhiều tác vụ học máy khác nhau, bao gồm:

- Phân loại: là một nhiệm vụ học máy trong đó các điểm dữ liệu được gán cho một trong hai hoặc nhiều lớp. Ví dụ, một mô hình phân loại có thể được sử dụng để phân loại các hình ảnh thành các lớp như “chó”, “mèo” hoặc “con bò”.

- Hồi quy: là một nhiệm vụ học máy trong đó các điểm dữ liệu được sử dụng để dự đoán giá trị của một biến. Ví dụ, một mô hình hồi quy có thể được sử dụng để dự đoán giá nhà dựa trên các thuộc tính như diện tích, số phòng và vị trí.

- Clustering: là một nhiệm vụ học máy trong đó các điểm dữ liệu được nhóm lại với nhau dựa trên sự tương đồng của chúng. Ví dụ, một mô hình clustering có thể được sử dụng để nhóm các khách hàng lại với nhau dựa trên sở thích mua sắm của họ.

KIP đặc biệt hữu ích cho các tác vụ trong đó tập dữ liệu lớn và các điểm dữ liệu có thể được biểu diễn dưới dạng vectơ.

4. Ví dụ về cách mà KIP hoạt động

Giả sử chúng ta có một tập dữ liệu gồm 10.000 điểm dữ liệu, mỗi điểm dữ liệu có hai thuộc tính. Chúng ta muốn xây dựng một mô hình phân loại có thể phân loại các điểm dữ liệu thành hai lớp.

Chúng ta có thể sử dụng KIP để chọn một tập con nhỏ 100 điểm dữ liệu từ tập dữ liệu gốc. Các điểm dữ liệu này được gọi là các điểm dữ liệu gây ra.

Sau đó, chúng ta có thể sử dụng các điểm dữ liệu gây ra để đào tạo một mô hình phân loại lớn, được gọi là mô hình Teacher (mô hình Thầy). Mô hình Teacher này có thể đạt được độ chính xác cao.

Cuối cùng, chúng ta có thể sử dụng mô hình Teacher để đào tạo một mô hình phân loại nhỏ hơn, được gọi là mô hình Student (giống mối quan hệ giữa thầy và trò, ngoài ra, còn có thể có cả mô hình Giảng viên Trợ giảng). Mô hình Student này có thể được sử dụng để phân loại các điểm dữ liệu còn lại trong tập dữ liệu gốc.

Mô hình Student sẽ nhỏ hơn mô hình Teacher và sẽ có thể phân loại các điểm dữ liệu còn lại trong tập dữ liệu gốc với độ chính xác tương đối cao.

Cách tiếp cận này có thể được sử dụng để giảm đáng kể kích thước của tập dữ liệu, tăng tốc độ xủ lý, mà không làm giảm đáng kể độ chính xác của mô hình.

5. Ưu điểm và nhược điểm

Ưu điểm:

- KIP có thể được sử dụng cho nhiều tác vụ học máy khác nhau.

- KIP có thể được sử dụng để xây dựng các mô hình học máy đơn giản hơn và dễ đào tạo hơn.

- KIP có thể được sử dụng để tăng tốc độ đào tạo của các mô hình học máy.

Nhược điểm:

- KIP có thể không hiệu quả cho các tác vụ trong đó các điểm dữ liệu không thể được biểu diễn dưới dạng vectơ.

- KIP có thể mất nhiều thời gian để thực thi cho các tập dữ liệu lớn.

6. So sánh KIP với MNIST và CIFAR10

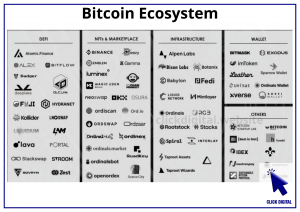

Cả 3 đều thuộc kỹ thuật Knowledge Distillation (chắt lọc thông tin), là loại kỹ thuật giúp tạo ra mô hình nhỏ và nhanh hơn nhưng vẫn giữ lại tính chính xác của mô hình lớn.

Dưới đây là một bảng so sánh KIP với MNIST và CIFAR10:

| Tính năng | KIP | MNIST | CIFAR10 |

|---|---|---|---|

| Kích thước | Có thể được giảm xuống | 60.000 | 60.000 |

| Độ phức tạp | Có thể được giảm xuống | 28×28 pixel | 32×32 pixel |

| Tác vụ | Có thể được sử dụng cho nhiều tác vụ | Phân loại chữ số viết tay | Phân loại hình ảnh |

| Lợi thế | Có thể giảm kích thước tập dữ liệu mà không làm giảm đáng kể độ chính xác của mô hình | Dễ dàng thu thập và chuẩn hóa | Nhiều loại đối tượng |

| Nhược điểm | Có thể mất nhiều thời gian để thực thi cho các tập dữ liệu lớn | Có thể không hiệu quả cho các tác vụ trong đó các điểm dữ liệu không thể được biểu diễn dưới dạng vectơ | Có thể không hiệu quả cho các tác vụ trong đó các điểm dữ liệu không thể được biểu diễn dưới dạng vectơ |

| Tổng quan | Một phương pháp giảm kích thước dữ liệu mạnh mẽ có thể được sử dụng cho nhiều tác vụ | Một tập dữ liệu phổ biến được sử dụng để đào tạo các mô hình học máy | Một tập dữ liệu phổ biến được sử dụng để đào tạo các mô hình học máy |

Kết: Nói tóm lại, Kernel Inducing Points (KIP) là một phương pháp giảm kích thước dữ liệu có thể được sử dụng cho nhiều tác vụ học máy khác nhau. KIP có một số lợi thế, bao gồm khả năng sử dụng cho nhiều tác vụ và khả năng xây dựng các mô hình học máy đơn giản hơn.

Vietnam Pham – Click Digital

Đầu tư vào trí tuệ nhân tạo bằng cách đầu tư token Saigon (ký hiệu: SGN) thông qua sàn giao dịch Pancakeswap: https://t.co/KJbk71cFe8 (đừng lo lắng về low liquidity) (cách mua: tìm hiểu trên Google về thao tác giao dịch trên sàn phi tập trung Pancakeswap, cực kỳ an toàn).

– Lợi nhuận sẽ dùng để mua lại SGN hoặc đốt bớt nguồn cung SGN để đẩy giá SGN tăng.

– Twitter: https://twitter.com/SaigonSGN135

– Gửi staking SGN lấy lãi suất tại trang: https://135web.net

Digital Marketing Specialist