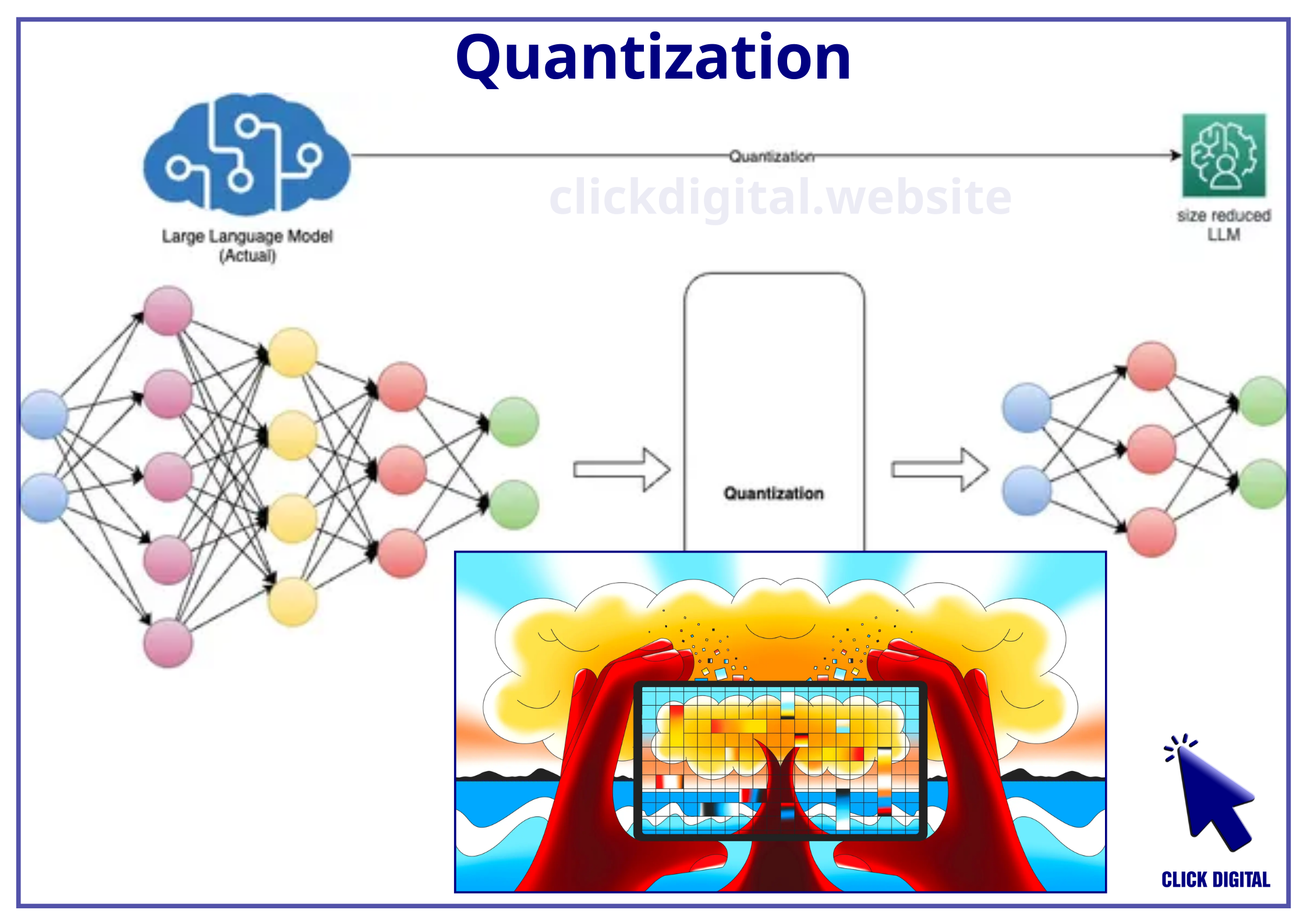

Bạn có biết rằng việc huấn luyện các mô hình ngôn ngữ lớn (LLM) ngày càng đắt đỏ hơn? Khi các LLM trở nên phức tạp hơn, việc giảm chi phí tính toán và năng lượng của chúng trở thành một thách thức quan trọng. Một giải pháp phổ biến là quanta hóa, nơi độ chính xác của các tham số được giảm từ tiêu chuẩn 16 bit dấu phẩy động (FP16) hoặc 32 bit dấu phẩy động (FP32) xuống các định dạng bit thấp hơn như 8 bit hoặc 4 bit.

Giảm độ chính xác xuống mức thấp có thể khiến mô hình bị mất thông tin quan trọng, dẫn đến hiệu suất giảm sút. Ví dụ, hãy tưởng tượng bạn đang cố gắng mô tả một bức tranh bằng cách sử dụng chỉ 10 màu khác nhau. Bạn sẽ không thể thể hiện chính xác tất cả các sắc thái và chi tiết trong bức tranh ban đầu. Tương tự như vậy, khi bạn giảm độ chính xác của các tham số trong mô hình ngôn ngữ, bạn sẽ loại bỏ một số thông tin tinh tế cần thiết cho việc xử lý ngôn ngữ.

BitNet là một kiến trúc transformer đặc biệt đại diện cho mỗi tham số chỉ bằng ba giá trị: (-1, 0, 1), mang lại quanta hóa cực đoan chỉ 1.58 bit mỗi tham số. Điều này tương đương với việc sử dụng chỉ 3 màu để mô tả bức tranh của bạn!

Table of Contents

1.58 bit Quanta hóa: Giới thiệu về BitNet

BitNet được giới thiệu bởi Microsoft Research, sử dụng quanta hóa cực đoan, biểu diễn mỗi tham số với chỉ ba giá trị: -1, 0 và 1. Điều này dẫn đến một mô hình chỉ sử dụng 1.58 bit mỗi tham số, giảm đáng kể yêu cầu tính toán và bộ nhớ.

Hãy tưởng tượng bạn có một cuốn sách rất dày chứa đầy thông tin. Bạn muốn thu nhỏ cuốn sách này để dễ dàng mang theo bên mình. BitNet giống như một phương pháp để nén cuốn sách, loại bỏ một số thông tin không cần thiết, nhưng vẫn giữ được ý nghĩa cơ bản.

Kiến trúc này sử dụng các phép tính cộng INT8 khi thực hiện phép nhân ma trận, trái ngược với các phép tính cộng và nhân FP16 của mô hình ngôn ngữ LLaMA. INT8 là một định dạng số nguyên 8 bit, đơn giản hơn và nhanh hơn FP16. Điều này cho phép BitNet thực hiện các phép tính nhanh hơn và hiệu quả hơn.

BitNet b1.58 cho phép giảm đáng kể năng lượng tiêu thụ, tiết kiệm 71.4 lần năng lượng hoạt động cho phép nhân ma trận so với LLaMA. Hãy tưởng tượng bạn đang chạy một chiếc xe hơi. BitNet giống như việc bạn thay đổi động cơ của xe để sử dụng ít nhiên liệu hơn, nhưng vẫn di chuyển được với tốc độ tương tự.

Kết quả huấn luyện trước với 1.58 bit

Trong nghiên cứu này, các nhà nghiên cứu đã thành công trong việc huấn luyện trước một mô hình Llama3 8B bằng kiến trúc BitNet, đạt được hiệu suất mạnh mẽ trên các tác vụ hạ nguồn. Huấn luyện trước mô hình có nghĩa là cung cấp cho mô hình một lượng lớn dữ liệu và cho phép nó học hỏi từ dữ liệu đó. Tuy nhiên, việc huấn luyện trước một LLM với 1.58 bit đòi hỏi nhiều tài nguyên và có thể không phù hợp với mọi người.

Hãy tưởng tượng bạn đang dạy một đứa trẻ học ngôn ngữ. Huấn luyện trước mô hình giống như việc bạn cho đứa trẻ đọc rất nhiều sách để nó có thể học được cách sử dụng ngôn ngữ một cách chính xác.

Điều chỉnh tinh chỉnh với 1.58 bit

Mục tiêu của nghiên cứu này là xem xét xem liệu có thể điều chỉnh tinh chỉnh một mô hình đã được huấn luyện trước với 1.58 bit hay không? Các nhà nghiên cứu đã thử nghiệm một số kỹ thuật để điều chỉnh tinh chỉnh một mô hình Llama3 8B đã được huấn luyện trước với kiến trúc BitNet.

Điều chỉnh tinh chỉnh mô hình có nghĩa là bạn thay đổi một số thông tin trong mô hình đã được huấn luyện trước để nó hoạt động tốt hơn trên một nhiệm vụ cụ thể.

Hãy tưởng tượng bạn đã học được cách chơi đàn guitar. Điều chỉnh tinh chỉnh mô hình giống như việc bạn tập luyện thêm để chơi một bài hát cụ thể một cách hoàn hảo.

Kết quả thử nghiệm

Kết quả cho thấy rằng điều chỉnh tinh chỉnh một mô hình đã được huấn luyện trước với 1.58 bit có thể đạt được hiệu suất khả quan.

Các thử nghiệm cho thấy rằng khi điều chỉnh tinh chỉnh từ các trọng số Llama3 8B đã được huấn luyện trước, mô hình hoạt động tốt hơn một chút nhưng không tốt như mong đợi.

Các nhà nghiên cứu đã xác định rằng việc sử dụng quanta hóa từng tensor có thể làm cho mô hình bị mất tất cả thông tin trước đó.

Hãy tưởng tượng bạn đang dạy một đứa trẻ học cách giải một bài toán. Bạn cho nó một số ví dụ để nó học hỏi, nhưng sau đó bạn thay đổi cách giải bài toán mà không cho nó biết. Đứa trẻ sẽ bị nhầm lẫn và không thể giải bài toán nữa. Tương tự như vậy, khi bạn sử dụng quanta hóa từng tensor, bạn thay đổi cách mô hình xử lý thông tin mà không cho nó biết. Cách làm này có thể khiến mô hình bị mất thông tin trước đó và hoạt động kém hiệu quả hơn.

Họ đã thử nghiệm một số kỹ thuật khác nhau để cải thiện kết quả, chẳng hạn như quanta hóa từng hàng và từng cột, hoặc thay đổi cách tính toán thang đo.

Để giải quyết vấn đề mất thông tin, các nhà nghiên cứu đã giới thiệu kỹ thuật quanta hóa dần dần, nơi quanta hóa được áp dụng dần dần vào các trọng số và hoạt động cho mỗi tensor.

Hãy tưởng tượng bạn đang dạy một đứa trẻ học cách đi xe đạp. Bạn không thể bắt nó ngay lập tức đi xe đạp mà không có bánh phụ. Thay vào đó, bạn phải dần dần loại bỏ bánh phụ cho đến khi đứa trẻ có thể đi xe đạp một mình. Tương tự như vậy, kỹ thuật quanta hóa dần dần cho phép mô hình học cách xử lý thông tin với độ chính xác thấp hơn một cách dần dần, tránh việc mất thông tin trước đó.

Kỹ thuật quanta hóa dần dần được chứng minh là hiệu quả trong việc cải thiện kết quả điều chỉnh tinh chỉnh.

Khi các nhà nghiên cứu mở rộng thử nghiệm sang 100 tỷ token, họ nhận thấy rằng mô hình đạt được hiệu suất gần với mô hình Llama 3 8B, nhưng vẫn kém hơn ở một số khía cạnh.

Thử nghiệm với các mô hình nhỏ hơn, chẳng hạn như SmolLM, cho thấy rằng kỹ thuật quanta hóa dần dần không hiệu quả bằng với các mô hình lớn hơn.

Bảng so sánh các phương pháp quanta hóa

| Phương pháp | Độ chính xác | Ưu điểm | Nhược điểm |

| FP16 (16 bit dấu phẩy động) | Cao | Độ chính xác cao | Nhu cầu bộ nhớ và tính toán cao |

| FP32 (32 bit dấu phẩy động) | Rất cao | Độ chính xác rất cao | Nhu cầu bộ nhớ và tính toán cực cao |

| 8 bit | Trung bình | Giảm đáng kể nhu cầu bộ nhớ và tính toán | Giảm độ chính xác |

| 4 bit | Thấp | Giảm đáng kể nhu cầu bộ nhớ và tính toán | Giảm độ chính xác đáng kể |

| BitNet (1.58 bit) | Cực thấp | Giảm đáng kể nhu cầu bộ nhớ và tính toán, Hiệu quả năng lượng cao | Có thể dẫn đến mất thông tin, Cần kỹ thuật đặc biệt để điều chỉnh tinh chỉnh |

Lưu ý:

- Bảng này chỉ so sánh các phương pháp quanta hóa về độ chính xác và hiệu quả.

- Các yếu tố khác như loại mô hình, nhiệm vụ, và tập dữ liệu cũng ảnh hưởng đến hiệu suất của từng phương pháp.

- BitNet là một phương pháp quanta hóa cực đoan, mang lại nhiều lợi ích nhưng cũng có những thách thức cần giải quyết.

Nhận xét

Quanta hóa cực đoan, như được minh chứng bởi BitNet, là một bước tiến đầy hứa hẹn trong việc giải quyết vấn đề về chi phí tính toán và năng lượng của các mô hình ngôn ngữ lớn. Mặc dù việc đạt được độ chính xác cực thấp với 1.58 bit mỗi tham số mang lại những lợi ích rõ rệt về hiệu suất, nhưng việc điều chỉnh tinh chỉnh các mô hình đã được huấn luyện trước với kiến trúc này vẫn là một thử thách. Kỹ thuật quanta hóa dần dần đã chứng minh được tiềm năng trong việc giải quyết vấn đề mất thông tin, mở ra con đường mới cho việc ứng dụng BitNet trong thực tế. Tuy nhiên, nghiên cứu sâu hơn về các kỹ thuật tối ưu hóa và những tác động của quanta hóa cực đoan đến hiệu suất của mô hình là cần thiết để khai thác đầy đủ tiềm năng của BitNet và thúc đẩy sự phát triển của các LLM hiệu quả hơn.

Kết luận

Kết quả của nghiên cứu này cho thấy rằng điều chỉnh tinh chỉnh các mô hình đã được huấn luyện trước với 1.58 bit là khả thi và có thể đạt được hiệu suất khả quan.

BitNet đã được chứng minh là hiệu quả trong việc mang lại hiệu suất mạnh mẽ so với các phương pháp cơ bản, đặc biệt là ở mức bit thấp hơn.

Nhìn chung, BitNet mở ra những khả năng mới để làm cho các LLM trở nên thực tế và có thể mở rộng hơn bằng cách giảm nhu cầu tính toán của chúng, đồng thời duy trì độ chính xác.

Digital Marketing Specialist